INTRODUCCIÓN: EL FIN DE LA ERA DE LA COMPUTACIÓN DE PROPÓSITO GENERAL

Durante décadas, la ley de Moore y la arquitectura x86 (Intel y AMD) definieron el ritmo del progreso tecnológico. El centro de datos era homogéneo: filas interminables de servidores «caja de pizza» ejecutando procesadores genéricos capaces de hacer cualquier cosa, pero ninguna de ellas de manera óptima. Esa era ha terminado.

Estamos inmersos en un cambio de paradigma tectónico, impulsado por una fuerza irresistible: la Inteligencia Artificial Generativa. Los Modelos de Lenguaje Grande (LLMs) como Gemini Ultra no son solo software; son devoradores de recursos computacionales a una escala que la infraestructura tradicional no puede soportar. La demanda de cómputo para entrenar e inferir estos modelos está superando la capacidad de producción de silicio y, más críticamente, la capacidad energética del planeta.

Ante este abismo, la computación de propósito general ha muerto. Ha nacido la era de la especialización radical.

En este nuevo teatro de operaciones, un jugador ha estado moviendo sus piezas con una previsión asombrosa durante más de una década: Google. Mientras el mundo miraba a NVIDIA como el único proveedor de «picos y palas» para la fiebre del oro de la IA, Google estaba construyendo, en relativo silencio, una fundición de silicio personalizada capaz de redefinir toda la pila tecnológica, desde el átomo hasta la aplicación.

Este artículo no es una simple revisión de productos. Es un análisis exhaustivo y técnico de cómo Google está ejecutando la estrategia de hardware más ambiciosa de la historia de la computación moderna. Diseccionaremos sus nuevas CPUs Axion basadas en ARM, que buscan romper la dependencia de x86 en la nube; analizaremos sus TPUs Ironwood (v5e), diseñadas para la eficiencia en la inferencia a escala masiva; y miraremos hacia el futuro distante con sus avances en computación cuántica.

Prepárense para sumergirse en las profundidades del silicio que impulsará la próxima década de innovación.

CAPÍTULO 1: LA NECESIDAD DE LA REINVENCIÓN. ¿POR QUÉ GOOGLE FABRICA SUS PROPIOS CHIPS?

Para entender Axion e Ironwood, primero debemos entender el problema que intentan resolver. Google no es una empresa de hardware tradicional que busca vender chips a terceros (principalmente). Google es, ante todo, el mayor consumidor de su propia computación.

Cuando operas a la escala de Google —indexando la web, sirviendo miles de millones de horas de YouTube, procesando billones de consultas de búsqueda y, ahora, entrenando los modelos de IA más grandes del mundo—, las ineficiencias minúsculas se multiplican por mil millones.

1.1. La Barrera de la Energía y el Coste Total de Propiedad (TCO)

El principal cuello de botella de la IA moderna no es solo la velocidad (FLOPs), sino la energía. Los centros de datos ya consumen porcentajes significativos de la electricidad mundial. Seguir escalando con GPUs monolíticas de 700W+ (como las H100 de NVIDIA) no es sostenible ni económica ni medioambientalmente para todas las cargas de trabajo. Google necesita chips que ofrezcan el máximo rendimiento por vatio.

1.2. La Integración Vertical y el Control del Stack

Apple demostró con sus chips Silicon (M1/M2/M3) que controlar el hardware y el software de forma conjunta produce ganancias de rendimiento exponenciales que el hardware genérico no puede igualar. Google busca lo mismo en el centro de datos. Al diseñar el chip (TPU), el compilador (XLA), el framework (JAX/TensorFlow) y el modelo final (Gemini), pueden optimizar cada nanosegundo del flujo de datos, eliminando cuellos de botella que existen cuando se mezclan tecnologías de diferentes proveedores.

1.3. La Seguridad en la Cadena de Suministro y la Soberanía Tecnológica

Depender de un único proveedor (como NVIDIA para IA o Intel/AMD para CPUs) es un riesgo estratégico existencial para un hiperescalador. Desarrollar su propio silicio otorga a Google control sobre su destino, inmunidad parcial ante crisis de suministro ajenas y la capacidad de iterar a su propia velocidad, no a la de sus proveedores.

CAPÍTULO 2: GOOGLE AXION. EL ASALTO ARM AL CENTRO DE DATOS

El anuncio de Google Axion marcó un punto de inflexión. Aunque Amazon (con Graviton) lleva años liderando la transición a ARM en la nube, la entrada de Google valida definitivamente que el futuro del servidor generalista no es x86.

2.1. ¿Qué es Axion? Anatomía de una CPU Cloud-Native

Axion es la primera CPU de centro de datos personalizada de Google basada en la arquitectura ARM. No es un chip para tu teléfono; es una bestia diseñada para el hiperescalado.

-

La Base: ARM Neoverse V2. Axion se basa en los diseños de núcleo de alto rendimiento de ARM, conocidos como Neoverse V2. Estos núcleos están optimizados para cargas de trabajo de infraestructura en la nube, bases de datos y microservicios.

-

El Diseño «System-on-Chip» (SoC) de Google. Google no se limita a comprar el diseño de ARM. Lo envuelve con su propia propiedad intelectual (IP). Esto incluye controladores de memoria personalizados, unidades de gestión de seguridad (Titan) y aceleradores de descarga especializados para tareas como la compresión de datos y el cifrado, liberando a los núcleos principales para el trabajo real.

2.2. La Ventaja Arquitectónica: Eficiencia vs. Legado

La arquitectura x86 (Intel/AMD) es una maravilla de la ingeniería, pero arrastra décadas de código heredado y un conjunto de instrucciones complejo (CISC) que requiere mucha energía para decodificar. ARM, con su conjunto de instrucciones reducido (RISC), es inherentemente más simple y eficiente energéticamente.

En el centro de datos, esto se traduce en:

-

Mayor densidad de núcleos: Se pueden empaquetar más núcleos Axion en el mismo espacio físico y con el mismo presupuesto térmico que los núcleos x86.

-

Rendimiento por vatio superior: Google afirma que Axion ofrece hasta un 30% más de rendimiento que las instancias basadas en ARM de la competencia (léase AWS Graviton3) y hasta un 50% más de rendimiento y un 60% más de eficiencia energética que las instancias comparables basadas en x86 de la generación actual.

2.3. El Caso de Uso de Axion: ¿Para qué sirve?

Axion no está diseñado para entrenar IA (para eso están las TPUs). Axion es el caballo de batalla para todo lo demás.

-

La columna vertebral de Google: Servicios como Spanner, BigQuery y la infraestructura publicitaria de Google se están migrando a Axion. El ahorro de costes internos es astronómico.

-

Cargas de trabajo de propósito general: Servidores web, bases de datos en memoria (Redis), microservicios en contenedores (Kubernetes) y procesamiento de medios. Para el cliente de Google Cloud, Axion promete un rendimiento mejorado a un coste menor para estas tareas esenciales.

CAPÍTULO 3: TPUs IRONWOOD (v5e). LA HIPER-ESPECIALIZACIÓN DE LA IA

Si Axion es el cerebro logístico del centro de datos, las TPUs (Tensor Processing Units) son el músculo creativo. Las TPUs son ASICs (Circuitos Integrados de Aplicación Específica) diseñados desde cero para una sola cosa: ejecutar las matemáticas matriciales que sustentan el aprendizaje profundo (Deep Learning).

«Ironwood» es el nombre en clave asociado a la generación v5e de TPUs de Google. Es crucial entender la «e»: significa Eficiencia.

3.1. La Evolución del TPU: De la Inferencia al Entrenamiento Masivo

Google lleva usando TPUs internamente desde 2015.

-

TPU v1: Solo inferencia.

-

TPU v2/v3: Entrenamiento e inferencia a gran escala, introduciendo la refrigeración líquida y los «Pods» masivos.

-

TPU v4: Un salto enorme en rendimiento, base de muchos modelos actuales.

-

TPU v5p (Performance) vs. v5e (Efficiency – Ironwood): Google ha bifurcado su línea. La v5p es la bestia de entrenamiento de fuerza bruta (competidor directo de H100). La v5e (Ironwood) es una obra maestra de equilibrio, diseñada para la inferencia a escala masiva y el entrenamiento de modelos medianos con la máxima eficiencia de costes y energía.

3.2. Arquitectura Ironwood: Diseñando para la Era de los Transformers

¿Qué hace que una TPU sea diferente de una GPU?

-

La Matriz Sistólica (Systolic Array): El corazón de la TPU. Mientras una GPU tiene miles de núcleos pequeños que deben acceder constantemente a la memoria (el cuello de botella de Von Neumann), una matriz sistólica pasa los datos a través de una red de unidades de procesamiento en un flujo continuo, como una cadena de montaje. Los datos se reutilizan masivamente dentro del chip antes de volver a la memoria. Esto es inmensamente eficiente para las multiplicaciones de matrices densas típicas de las redes neuronales.

-

Optimización para Transformers: Ironwood está diseñada pensando en arquitecturas como Transformer (la «T» de GPT y BERT). Incluye hardware dedicado para manejar operaciones específicas de estos modelos, como la atención dispersa (sparse attention), acelerando drásticamente la inferencia de LLMs.

-

Interconexión ICI (Inter-Chip Interconnect): El secreto de Google no es solo el chip, sino cómo se conectan. Las TPUs Ironwood se enlazan directamente entre sí mediante una red de latencia ultrabaja y ancho de banda masivo, sin pasar por redes Ethernet tradicionales. Esto permite que miles de chips actúen como una sola computadora gigante (un «Pod»). Un Pod de TPU v5e puede escalar hasta 256 chips en una topología de toro 2D, ofreciendo un rendimiento de supercomputación a una fracción del coste de sistemas comparables.

3.3. El Impacto de Ironwood: Inferencia de LLM para las Masas

Entrenar un modelo como Gemini es caro, pero «servirlo» (inferencia) a mil millones de usuarios es un desafío económico aún mayor. Ironwood es la respuesta de Google a este problema. Ofrece el mejor rendimiento por dólar para ejecutar modelos grandes en producción. Es el motor que permite que la IA de Google sea omnipresente y rápida sin quebrar la empresa en costes de electricidad.

CAPÍTULO 4: LA GUERRA FRÍA DEL HARDWARE. GOOGLE vs. NVIDIA

Esta es la pregunta que obsesiona a la industria: ¿Pueden las TPUs de Google destronar a las GPUs de NVIDIA? La respuesta es compleja y matizada. No es una guerra de aniquilación, sino de ecosistemas y especialización.

4.1. NVIDIA: La Hegemonía de la Fuerza Bruta y CUDA

La ventaja de NVIDIA es doble:

-

Hardware Monstruoso: Sus GPUs H100 (y las futuras B200 Blackwell) son maravillas de la ingeniería, ofreciendo un rendimiento FP8/FP16 inigualable para el entrenamiento de fuerza bruta de los modelos más grandes.

-

El Foso de CUDA: El verdadero poder de NVIDIA es su software. CUDA es el estándar de facto para la programación paralela desde hace 15 años. Millones de investigadores, miles de librerías y todo el ecosistema académico y empresarial está construido sobre CUDA. Romper esta inercia es increíblemente difícil.

4.2. El Ataque de Google: Eficiencia y el Stack Alternativo

Google no intenta ganar a NVIDIA en su propio juego (vender GPUs a todo el mundo). Google juega a optimizar su nube.

-

Eficiencia vs. Fuerza Bruta: Mientras NVIDIA empuja los límites térmicos (700W+ por chip), Google con Ironwood prioriza la eficiencia del sistema completo. Para muchas empresas, el coste total (energía + hardware) es más importante que el rendimiento pico absoluto.

-

El Stack de Software JAX/XLA: Google está construyendo la alternativa a CUDA.

-

JAX: Un framework de Python flexible y potente, cada vez más amado por los investigadores de vanguardia, que se compila de forma nativa y eficiente en TPUs (y también en GPUs).

-

XLA (Accelerated Linear Algebra): Un compilador de dominio específico que toma el código de JAX, TensorFlow o PyTorch y lo optimiza agresivamente para el hardware subyacente. XLA es la magia que permite que el software de alto nivel exprima el hardware de la TPU sin que el programador tenga que escribir código de bajo nivel.

-

4.3. El Veredicto Actual: Coexistencia Incómoda

Hoy por hoy, NVIDIA sigue siendo el rey indiscutible para el entrenamiento de vanguardia de los modelos más grandes (pensemos en GPT-4 o modelos de fundición masivos). Sin embargo, Google ha creado una alternativa viable y superior en costes para:

-

Sus propias cargas de trabajo internas (que son inmensas).

-

Empresas que usan Google Cloud y buscan la mejor relación rendimiento/precio para inferencia a gran escala y entrenamiento de modelos medianos/grandes.

NVIDIA está preocupada. No porque vayan a perder el mercado mañana, sino porque los hiperescaladores (Google, AWS, Microsoft) están demostrando que hay vida más allá de CUDA y que el silicio personalizado es el futuro de la nube.

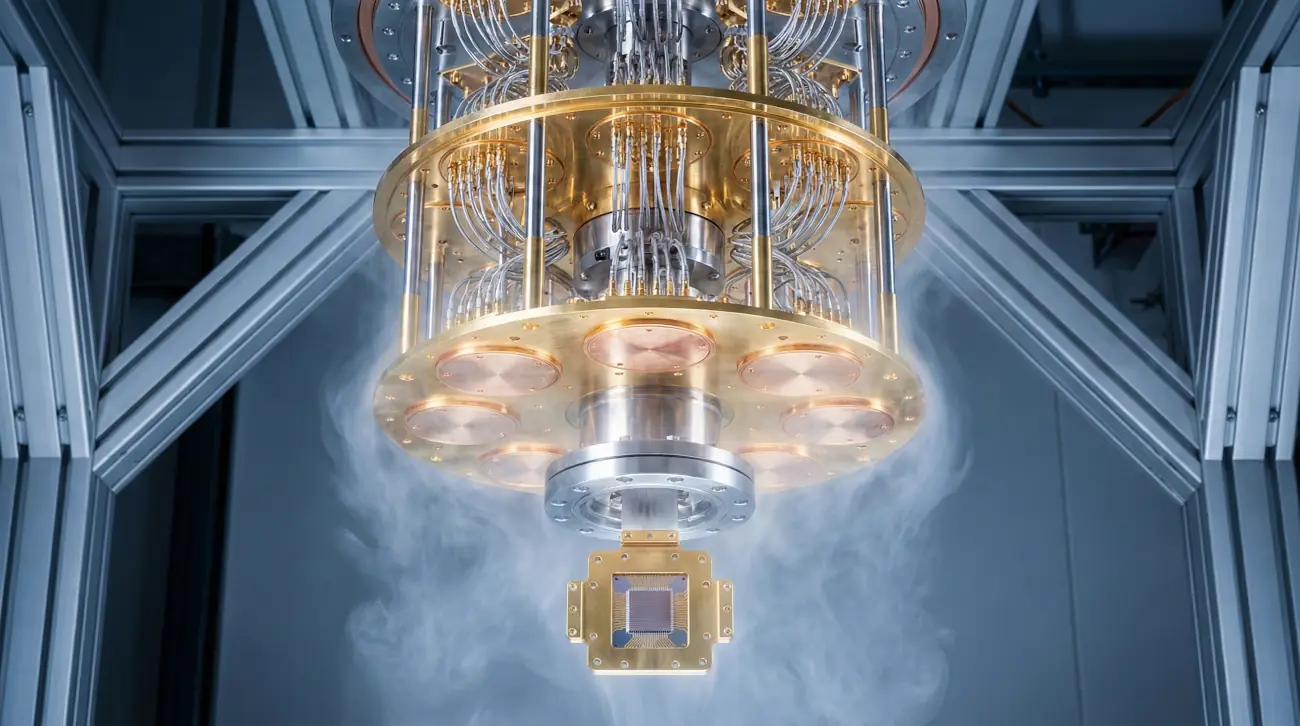

CAPÍTULO 5: MÁS ALLÁ DEL SILICIO CLÁSICO. EL SALTO CUÁNTICO DE GOOGLE

Mientras Axion e Ironwood optimizan la computación clásica hasta sus límites físicos, Google Quantum AI trabaja en un paradigma completamente diferente para resolver problemas que ninguna supercomputadora clásica, por grande que sea, podrá jamás abordar.

5.1. Sycamore y la «Supremacía Cuántica» (2019)

Google hizo historia en 2019 con su procesador Sycamore de 53 qubits. Anunciaron haber alcanzado la «supremacía cuántica», realizando en 200 segundos un cálculo específico (muestreo de circuitos aleatorios) que, según ellos, habría llevado 10.000 años a la supercomputadora clásica más potente de la época. Aunque la cifra fue disputada (IBM dijo que eran 2.5 días, no 10.000 años), el hito simbólico fue innegable: habíamos entrado en la era NISQ (Noisy Intermediate-Scale Quantum).

5.2. El Desafío Actual: La Corrección de Errores Cuánticos

Los qubits actuales son increíblemente frágiles. El más mínimo ruido térmico o electromagnético provoca «decoherencia», arruinando el cálculo. Sycamore es potente, pero ruidoso.

La estrategia actual de Google no es solo añadir más qubits ruidosos, sino crear un «Qubit Lógico».

-

Un qubit lógico no es un solo qubit físico. Es un conjunto de muchos qubits físicos (quizás 1.000 o más) que trabajan juntos usando códigos de corrección de errores para actuar como un solo qubit perfecto y estable.

-

En 2023, Google demostró por primera vez que al aumentar el número de qubits físicos en un esquema de corrección de errores, la tasa de error realmente disminuía. Esto fue un hito científico monumental, demostrando que la computación cuántica tolerante a fallos es teóricamente posible.

5.3. La Hoja de Ruta hacia el 2030: El Ordenador Cuántico Útil

El objetivo de Google es construir un ordenador cuántico con corrección de errores de un millón de qubits físicos para finales de la década.

-

Aplicaciones Reales: Esto no servirá para ejecutar Windows más rápido. Servirá para simular moléculas complejas para el descubrimiento de fármacos, diseñar nuevos materiales (catalizadores para la fijación de nitrógeno, mejores baterías), optimizar problemas logísticos globales y, potencialmente, romper la criptografía actual (aunque esto último es una carrera contra la criptografía post-cuántica).

5.4. La Convergencia: ¿TPUs controlando Qubits?

Existe una sinergia fascinante. Los sistemas cuánticos necesitan sistemas de control clásicos extremadamente rápidos y precisos para manipular los qubits y leer sus estados en nanosegundos. La experiencia de Google en silicio personalizado de alta velocidad (como las TPUs y el hardware de red asociado) es crucial para construir la infraestructura que rodea y controla el chip cuántico. El futuro probablemente verá centros de datos híbridos donde CPUs, TPUs y QPUs (Quantum Processing Units) trabajen en conjunto.

CONCLUSIÓN: LA NUEVA MATRIZ COMPUTACIONAL

El lanzamiento de las CPUs Axion y la maduración de las TPUs Ironwood no son meros anuncios de productos; son la declaración de independencia de Google respecto a la cadena de suministro de hardware tradicional.

Hemos entrado en la era de la computación definida por el software e impulsada por silicio personalizado. En este nuevo mundo, el ganador no es quien tiene el chip más rápido en un benchmark sintético, sino quien posee la integración más profunda de toda la pila tecnológica, desde la puerta lógica hasta la interfaz de usuario.

Google está construyendo una matriz computacional propia. Una donde las CPUs Axion manejan la logística general con eficiencia ARM, las TPUs Ironwood aceleran la inteligencia artificial a escala planetaria con una arquitectura sistólica optimizada, y los futuros procesadores cuánticos Sycamore esperan en los márgenes para abordar lo imposible.

Para el desarrollador, el arquitecto de sistemas y el CTO, la lección es clara: el hardware vuelve a importar, y la nube que elijas determinará no solo el software que puedes ejecutar, sino el silicio que lo impulsará. La hegemonía de x86 y CUDA está siendo desafiada, y la diversidad resultante solo puede significar una cosa: una aceleración aún mayor en el ritmo de la innovación tecnológica humana.

💬 Preguntas y Respuestas (FAQ)

1. ¿En qué se diferencia fundamentalmente una CPU Google Axion de un procesador Intel o AMD tradicional?

1. ¿En qué se diferencia fundamentalmente una CPU Google Axion de un procesador Intel o AMD tradicional?

La diferencia fundamental radica en la arquitectura del conjunto de instrucciones (ISA). Intel y AMD utilizan la arquitectura x86, que es de tipo CISC (Complex Instruction Set Computing). Es potente y compatible con décadas de software heredado, pero sus instrucciones complejas requieren más transistores y energía para decodificar. Google Axion utiliza la arquitectura ARM, que es de tipo RISC (Reduced Instruction Set Computing). RISC utiliza instrucciones más simples y uniformes, lo que permite diseñar chips más eficientes energéticamente, con mayor densidad de núcleos y mejor rendimiento por vatio para cargas de trabajo modernas en la nube y microservicios que no dependen del legado x86.

2. Si las TPUs Ironwood (v5e) son tan buenas, ¿por qué la mayoría de la industria sigue desesperada por comprar GPUs NVIDIA H100?

2. Si las TPUs Ironwood (v5e) son tan buenas, ¿por qué la mayoría de la industria sigue desesperada por comprar GPUs NVIDIA H100?

Es una cuestión de ecosistema y propósito. Las NVIDIA H100 son actualmente imbatibles en rendimiento bruto para el entrenamiento de los modelos de IA más gigantescos y vanguardistas, gracias a su hardware y, crucialmente, al ecosistema de software CUDA, que es el estándar de la industria. Casi toda la investigación académica y las herramientas de IA están construidas sobre CUDA. Las TPUs Ironwood v5e de Google están optimizadas para la eficiencia y la inferencia a gran escala (servir el modelo una vez entrenado), y aunque son excelentes para el entrenamiento, brillan dentro del ecosistema de software de Google (JAX/TensorFlow/XLA). Para una empresa externa, migrar de CUDA al stack de Google tiene una curva de aprendizaje y un coste de fricción que mantiene alta la demanda de NVIDIA.

3. ¿Qué significa que las TPUs usan una arquitectura de "matriz sistólica" y por qué es importante para la IA?

3. ¿Qué significa que las TPUs usan una arquitectura de "matriz sistólica" y por qué es importante para la IA?

Imagina una CPU o GPU tradicional como un chef que tiene que ir a la despensa (memoria) cada vez que necesita un ingrediente para cortar (procesar). La IA requiere billones de estas operaciones (multiplicación de matrices). Este viaje constante a la memoria es el principal cuello de botella (Von Neumann). Una matriz sistólica, usada en las TPUs, es como una línea de ensamblaje de chefs. Los datos entran por un lado y fluyen a través de una red de unidades de procesamiento, siendo operados en cada paso y pasando los resultados parciales al siguiente vecino sin tener que volver a la memoria principal constantemente. Esto maximiza drásticamente el rendimiento y la eficiencia energética para las cargas de trabajo específicas de la IA.

4. ¿Están las CPUs Axion disponibles para que cualquier usuario de Google Cloud las utilice?

4. ¿Están las CPUs Axion disponibles para que cualquier usuario de Google Cloud las utilice?

Sí, Google ha anunciado que las CPUs Axion estarán disponibles para los clientes de Google Cloud. No solo se usan internamente para servicios como Google Ads o YouTube, sino que se ofrecerán como tipos de instancia en Google Compute Engine, Google Kubernetes Engine (GKE) y otros servicios gestionados. Esto permite a las empresas externas beneficiarse de las mejoras de rendimiento y coste que ofrece el silicio personalizado de Google para sus propias aplicaciones.

5. ¿Qué es el compilador XLA y por qué es el "arma secreta" de Google contra NVIDIA CUDA?

5. ¿Qué es el compilador XLA y por qué es el "arma secreta" de Google contra NVIDIA CUDA?

XLA (Accelerated Linear Algebra) es un compilador de aprendizaje automático. Su función es cerrar la brecha entre el código de alto nivel (escrito en frameworks como TensorFlow, JAX o PyTorch) y el hardware específico (TPU, GPU o CPU). El «arma secreta» es que XLA analiza el gráfico de cómputo completo del modelo de IA y realiza optimizaciones globales que un compilador tradicional no puede ver. Por ejemplo, puede fusionar múltiples operaciones pequeñas en una sola operación grande y optimizada para la matriz sistólica de la TPU. Esto permite a los desarrolladores escribir código agnóstico y dejar que XLA exprima el máximo rendimiento del silicio de Google, reduciendo la necesidad de escribir código de bajo nivel específico como en CUDA.

6. ¿Ha logrado Google la "supremacía cuántica" y qué significa eso realmente en 2024/2025?

6. ¿Ha logrado Google la "supremacía cuántica" y qué significa eso realmente en 2024/2025?

Google afirmó haber logrado la supremacía cuántica en 2019 con su chip Sycamore, realizando un cálculo específico (muestreo de circuitos aleatorios) exponencialmente más rápido que una supercomputadora clásica. Sin embargo, el término es controvertido y un objetivo móvil, ya que los algoritmos clásicos también mejoran. En la actualidad, el enfoque ha cambiado de la mera «supremacía» en una tarea inútil a la «utilidad cuántica». Estamos en la era NISQ (cuántica de escala intermedia ruidosa), donde los chips tienen suficientes qubits para hacer cosas interesantes, pero son demasiado ruidosos para algoritmos revolucionarios. El verdadero hito que Google persigue ahora es la «corrección de errores cuánticos» para crear qubits lógicos estables, que es el requisito previo para una computación cuántica verdaderamente útil.

7. ¿Cuál es la diferencia entre un TPU "Pod" y un simple servidor con muchas GPUs?

7. ¿Cuál es la diferencia entre un TPU "Pod" y un simple servidor con muchas GPUs?

La diferencia es la escala y la interconexión. Un servidor GPU típico tiene 8 GPUs conectadas por NVLink dentro de la caja, pero para conectar múltiples servidores se usa Ethernet o InfiniBand, lo que introduce latencia. Un TPU «Pod» de Google es una supercomputadora diseñada como una sola unidad. Utiliza una interconexión óptica propietaria (ICI) que enlaza miles de chips TPU directamente entre sí en una topología de toro 2D o 3D. Esto permite una latencia ultrabaja y un ancho de banda masivo a través de miles de chips, haciendo que el software perciba al Pod entero casi como si fuera un solo acelerador gigante, algo esencial para entrenar modelos de IA que son demasiado grandes para caber en una sola máquina.

8. ¿Reemplazarán los chips cuánticos de Google a las TPUs y CPUs en el futuro?

8. ¿Reemplazarán los chips cuánticos de Google a las TPUs y CPUs en el futuro?

No, absolutamente no. La computación cuántica no es una versión «más rápida» de la computación clásica; es un paradigma fundamentalmente diferente. Los ordenadores cuánticos son pésimos para tareas cotidianas como ejecutar un sistema operativo, servir una página web o incluso realizar la mayoría de los cálculos de IA actuales. Son excelentes solo para una clase muy específica de problemas que involucran una complejidad combinatoria masiva (simulación química, optimización compleja, ciertos problemas matemáticos). El futuro es híbrido: las CPUs Axion manejarán la lógica general, las TPUs Ironwood manejarán la IA y el aprendizaje profundo, y los chips cuánticos Sycamore actuarán como co-procesadores hiper-especializados para problemas intratables clásicamente, todos trabajando juntos en el centro de datos.

9. ¿Cómo afecta el desarrollo de Axion e Ironwood al usuario medio de servicios de Google como Gmail, Fotos o Búsqueda?

9. ¿Cómo afecta el desarrollo de Axion e Ironwood al usuario medio de servicios de Google como Gmail, Fotos o Búsqueda?

El impacto es invisible pero profundo. Significa que servicios que requieren una IA intensiva, como las nuevas funciones de «Ayúdame a escribir» en Gmail, la edición mágica en Google Fotos o los resúmenes generativos en la Búsqueda (SGE), pueden implementarse a escala global para miles de millones de usuarios sin que Google quiebre por los costes de energía o hardware. Las TPUs Ironwood v5e permiten que la inferencia de estos modelos sea rápida y económicamente viable, manteniendo los servicios gratuitos o de bajo coste y mejorando su capacidad de respuesta y calidad con modelos más grandes y complejos.

10. ¿Qué es JAX y por qué está ganando terreno frente a TensorFlow y PyTorch en la investigación de IA de vanguardia?

10. ¿Qué es JAX y por qué está ganando terreno frente a TensorFlow y PyTorch en la investigación de IA de vanguardia?

JAX es un framework desarrollado por Google Research que está ganando mucha tracción. A diferencia de TensorFlow (que puede ser verboso y complejo) o PyTorch (que es excelente pero a veces más lento en TPUs), JAX ofrece una flexibilidad increíble al combinar NumPy (la biblioteca estándar para matemáticas en Python) con diferenciación automática y compilación XLA Just-In-Time (JIT). Esto permite a los investigadores escribir código matemático complejo de forma muy natural en Python y que se compile automáticamente para ejecutarse a máxima velocidad en TPUs o GPUs. Su diseño funcional y su capacidad para manejar paralelismo complejo lo hacen ideal para la investigación de modelos de frontera, y es el sustrato sobre el que Google está construyendo su próxima generación de herramientas de IA.