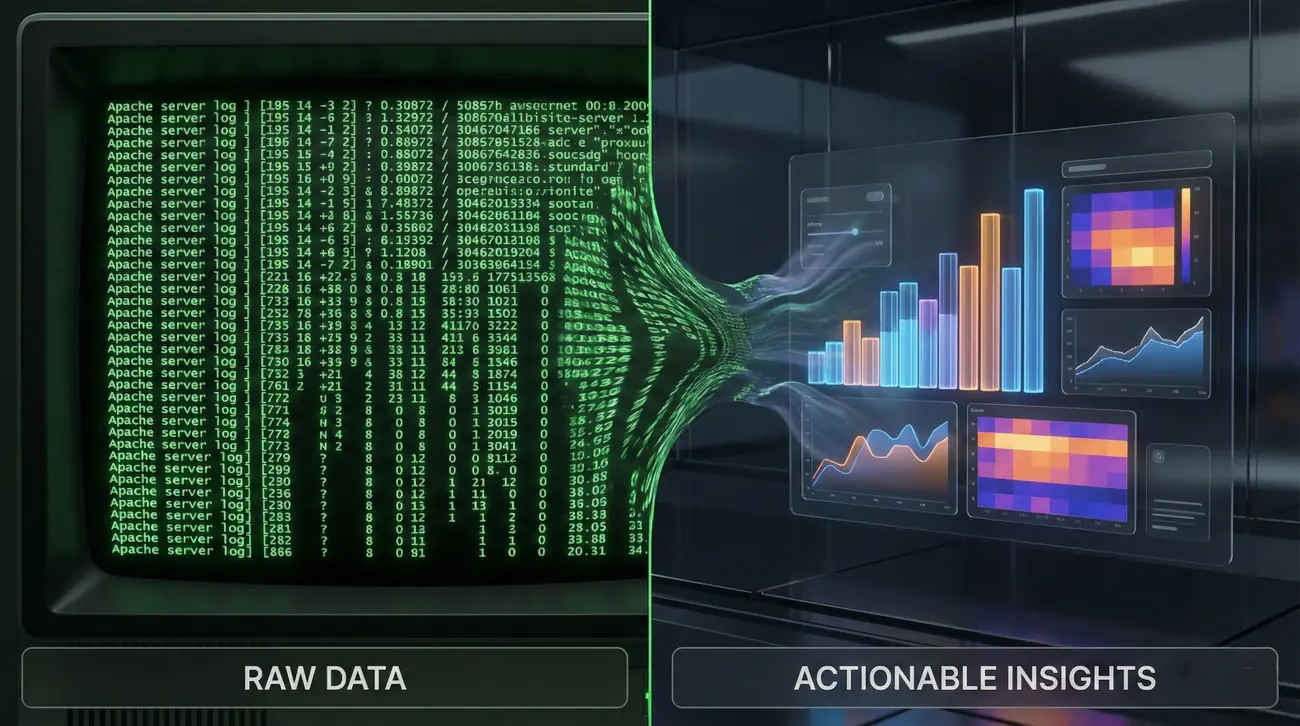

En el vasto océano del SEO, la mayoría de los profesionales navegan mirando las estrellas (keyword research) o estudiando las corrientes superficiales (backlinks y contenido). Sin embargo, existe una dimensión más profunda, un lugar donde no existen las estimaciones ni las suposiciones, sino la verdad absoluta y matemática de lo que ocurre en tu sitio web. Ese lugar son los Logs del Servidor.

Mientras herramientas como Google Search Console (GSC) o Ahrefs nos ofrecen una visión muestral o externa de la realidad, el análisis de logs nos ofrece la visión forense exacta. Nos dice con precisión quirúrgica cuándo pasó Googlebot, qué pidió, qué respuesta recibió y cuánto tiempo tardó.

Si gestionas un sitio web grande (e-commerce, medios de comunicación, marketplaces) y no estás analizando tus logs, estás volando a ciegas. Este artículo es tu manual de vuelo instrumental. Vamos a ir mucho más allá de las palabras clave para entender la infraestructura técnica que decide si tu contenido merece ser indexado o ignorado.

Capítulo 1: La Verdad Está en el Archivo de Texto. ¿Qué es un Log?

Para dominar el análisis de logs, primero debemos entender la materia prima.

1.1 Anatomía de una Petición

Cada vez que un usuario humano o un bot (como Googlebot) solicita una URL de tu web, el servidor web (Apache, Nginx, IIS, LiteSpeed) registra esa interacción en un archivo de texto plano. Esto es inmutable.

Una línea típica de log en formato Common Log Format o Combined Log Format se ve así:

66.249.66.1 - - [13/Dec/2025:10:55:36 +0000] "GET /categoria/zapatillas-deporte HTTP/1.1" 200 4523 "-" "Mozilla/5.0 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)"

Vamos a diseccionarlo:

-

IP (66.249.66.1): La dirección desde la que se hace la petición. Fundamental para verificar si es realmente Google o un impostor.

-

Timestamp ([13/Dec…]): El momento exacto, al segundo.

-

Método y URL (GET /categoria…): Qué pidió el bot.

-

Código de Estado (200): La respuesta del servidor (OK, Error, Redirección).

-

Tamaño (4523): Los bytes descargados.

-

User-Agent («Mozilla/5.0… Googlebot…»): La «tarjeta de identificación» del visitante.

1.2 Por qué GSC no es suficiente

Google Search Console tiene un informe de «Estadísticas de rastreo». Es útil, sí, pero es limitado:

-

-

Muestreo: GSC a menudo agrupa datos o no muestra el 100% de las peticiones en sitios muy grandes.

-

Retención: Los datos históricos son limitados.

-

Granularidad: No puedes cruzar fácilmente estos datos con tus datos de negocio (ingresos por URL, visitas orgánicas) para análisis complejos.

-

Otros Bots: GSC solo te habla de Google. ¿Qué pasa con Bing, DuckDuckGo, o los bots de IA como GPTBot que podrían estar saturando tu servidor?

-

Capítulo 2: Acceso y Herramientas. El Primer Obstáculo

El mayor desafío del análisis de logs no es técnico, es burocrático. Conseguir acceso a los archivos suele requerir negociar con el equipo de DevOps o TI.

2.1 Tipos de Acceso

-

Servidores Dedicados/VPS: Tienes acceso root. Los logs suelen estar en

/var/log/apache2/o/var/log/nginx/. -

Hosting Compartido/Cpanel: Suelen ofrecer una opción de «Raw Access Logs» para descargar.

-

CDNs (Cloudflare/AWS Cloudfront): Aquí la cosa se complica. Las peticiones a veces no llegan a tu servidor de origen si la CDN las sirve desde la caché. Necesitas activar el «Logpush» de Cloudflare o analizar los logs de S3 en AWS para tener la imagen completa. El análisis de logs moderno DEBE incluir los logs del Edge (CDN).

2.2 El Arsenal de Herramientas

No intentes leer esto en el Bloc de Notas.

-

Screaming Frog Log File Analyser: El estándar de la industria para SEOs. Potente, visual y específico para nuestra tarea.

-

ELK Stack (Elasticsearch, Logstash, Kibana): Para sitios empresariales masivos. Permite visualización en tiempo real.

-

Splunk: La opción premium empresarial.

-

Línea de Comandos (Grep/Awk): Para los puristas y rápidos diagnósticos en servidores Linux.

-

Ejemplo:

grep "Googlebot" access.log | grep "404" | wc -l(Cuenta cuántos errores 404 encontró Googlebot).

-

Capítulo 3: Crawl Budget. La Moneda de Cambio del SEO

El «Presupuesto de Rastreo» es la cantidad de recursos (tiempo y ancho de banda) que Google está dispuesto a invertir en tu sitio. Si tienes 1 millón de páginas pero Google solo rastrea 1000 al día, tardará años en ver tus cambios.

3.1 Detección del Desperdicio (Crawl Waste)

El análisis de logs te dirá exactamente dónde está perdiendo tiempo Google.

-

Parámetros de URL inútiles: ¿Está Google rastreando

/producto?color=rojo&talla=L&sessionID=123? Si esas URLs están canonicalizadas a/producto, estás tirando presupuesto a la basura. -

Faceted Navigation: Los filtros de e-commerce son agujeros negros para los bots. Los logs te revelarán si el bot ha caído en una trampa de combinaciones infinitas.

-

Recursos estáticos: ¿Googlebot pasa demasiado tiempo descargando imágenes no optimizadas o archivos JS pesados?

3.2 Frecuencia de Rastreo vs. Importancia

Este es el análisis rey. Cruza tus datos de logs con la estructura de tu sitio.

-

El Gráfico de Dispersión: Eje X = Nivel de profundidad de la URL. Eje Y = Hits de Googlebot.

-

El Objetivo: Tus páginas de Nivel 1 (Home, Categorías principales) y tus «Money Pages» (Productos Top Ventas) deberían tener la mayor frecuencia de rastreo.

-

La Alerta: Si tus productos más vendidos se rastrean una vez al mes, y tus términos y condiciones se rastrean a diario, tienes un problema grave de arquitectura interna.

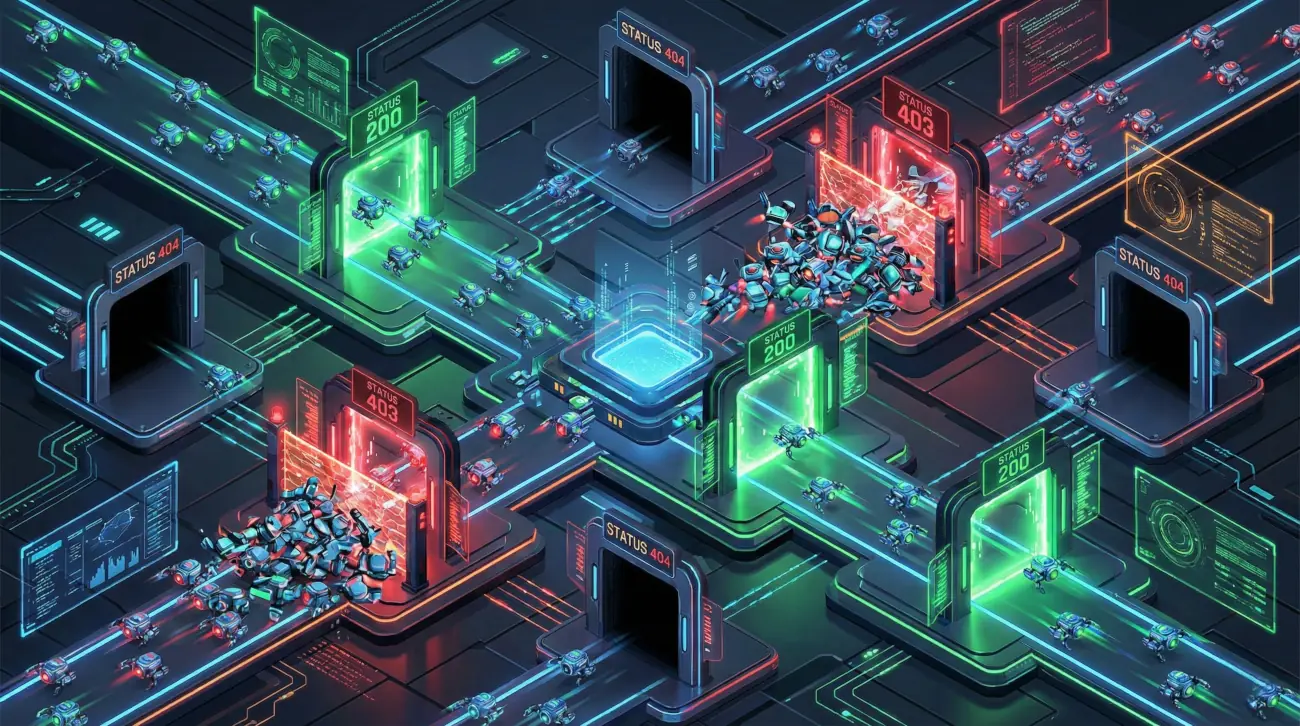

Capítulo 4: Códigos de Estado. El Chequeo de Salud

Los logs no mienten sobre cómo responde tu servidor.

4.1 La Plaga de los 301 (Cadenas de Redirección)

Los crawlers siguen redirecciones, pero cada salto consume presupuesto y diluye el PageRank.

-

Análisis: Identifica URLs que reciben hits de bots y devuelven un 301. Rastrea el destino. Si el bot sigue golpeando la URL antigua meses después de la migración, es porque tienes enlaces internos (o backlinks externos fuertes) apuntando a la versión vieja. Corrígelos en el origen.

4.2 Los 404 Invisibles (Soft 404 vs Hard 404)

A veces, tu CMS muestra una página de «Producto no encontrado» pero devuelve un código 200 OK. Eso es un Soft 404 y es veneno para el SEO. Sin embargo, el log te mostrará los verdaderos 404.

-

Caso de uso: Detectar productos descatalogados que siguen recibiendo atención de Googlebot. ¿De dónde viene el bot? Los logs a menudo incluyen el «Referer». Si viene de un enlace interno, elimínalo. Si viene de fuera, haz una 301 a la categoría superior.

4.3 El Peligro de los 5xx

Los errores de servidor (500, 503) son señales para Google de que tu sitio no es fiable.

-

Patrones: ¿Ocurren los errores 500 solo cuando Googlebot aumenta la velocidad de rastreo? Esto indica que tu servidor no aguanta la carga del bot. Necesitas mejorar tu hosting o limitar la velocidad de rastreo en GSC.

Capítulo 5: Páginas Huérfanas y Zombis. Lo Que Nadie Ve

Aquí es donde el análisis de logs brilla por encima de un rastreo tradicional con Screaming Frog.

5.1 ¿Qué es una Página Huérfana?

Es una página que existe en tu servidor, recibe tráfico (quizás de campañas antiguas, redes sociales o sitemaps viejos), pero no tiene enlaces internos. Un crawler tradicional (como Screaming Frog en modo spider) nunca la encontrará porque sigue enlaces. Pero el Log sí la ve, porque Googlebot (o usuarios) la visitan.

5.2 Estrategia de Recuperación

-

Exporta la lista de URLs rastreadas por Googlebot desde los logs.

-

Cruza esa lista con tu rastreo de Screaming Frog de la estructura actual.

-

Resultado: Las URLs que están en los logs pero NO en el rastreo de estructura son tus huérfanas.

-

Acción: ¿Son valiosas? Enlázalas internamente. ¿Son basura? Elimínalas (410) o redirígelas (301).

Capítulo 6: Mobile-First Indexing y Renderizado

El mundo es móvil, y tus logs deben confirmarlo.

6.1 Verificación de Googlebot Smartphone

Debes filtrar tus logs por User-Agent. Hoy en día, el 80-100% de las peticiones deberían provenir de Googlebot Smartphone. Si todavía ves una mayoría de Googlebot Desktop, es posible que Google tenga problemas para renderizar tu versión móvil o que tengas una configuración técnica antigua (m-dot sites) mal implementada.

6.2 El Coste del JavaScript

Aquí entramos en terreno avanzado. Googlebot tiene dos olas de indexación:

-

Crawling (HTML): Rápido y barato.

-

Rendering (JS): Lento y caro (Render Budget). Analizando la diferencia de tiempo entre la petición del HTML y la petición de los recursos JS/CSS asociados, puedes inferir problemas de renderizado. Si Googlebot pide el HTML pero nunca vuelve a por los archivos JS críticos, es posible que no esté renderizando tu contenido correctamente.

Capítulo 7: Seguridad y Limpieza de Bots Maliciosos

No todo lo que brilla es Google.

7.1 Spoofing (Suplantación)

Muchos scrapers y herramientas de hacking se presentan como «Googlebot» en el User-Agent para saltarse bloqueos.

-

La Prueba de Fuego: Debes realizar una búsqueda de DNS inversa (Reverse DNS Lookup) sobre las IPs que dicen ser Googlebot. Si la IP

1.2.3.4dice ser Googlebot pero el DNS no resuelve agooglebot.comogoogle.com, es un impostor. -

Acción: Bloquea esas IPs en tu firewall o .htaccess. Están consumiendo recursos y ensuciando tus datos.

Conclusión: De la Suposición a la Ciencia

El análisis de logs transforma el SEO de un arte adivinatorio a una ciencia de datos. Te permite:

-

Optimizar tu presupuesto de rastreo para que Google vea lo importante.

-

Limpiar tu arquitectura web de errores silenciosos.

-

Recuperar contenido valioso que habías dejado huérfano.

-

Entender la realidad móvil de tu sitio.

En un ecosistema digital cada vez más competitivo, donde la IA generará toneladas de contenido, la eficiencia técnica será el gran diferenciador. Quien mejor gestione los recursos de Googlebot, ganará la carrera de la indexación.

💬 Preguntas y Respuestas (FAQ)

1. ¿Con qué frecuencia debería realizar un análisis de logs en mi sitio web?

1. ¿Con qué frecuencia debería realizar un análisis de logs en mi sitio web?

Para sitios pequeños o medianos (menos de 10.000 URLs), una auditoría trimestral suele ser suficiente para detectar problemas de salud. Sin embargo, para grandes e-commerce, medios de noticias o sitios con millones de URLs, el análisis de logs debe ser continuo y automatizado. Se recomienda configurar dashboards en tiempo real (con ELK o Datadog) para monitorizar códigos 5xx o caídas drásticas en la frecuencia de rastreo, lo cual podría indicar un problema técnico grave tras un deploy.

2. Mi sitio está alojado en Shopify/Wix y no me dan acceso a los logs. ¿Qué puedo hacer?

2. Mi sitio está alojado en Shopify/Wix y no me dan acceso a los logs. ¿Qué puedo hacer?

Este es el gran inconveniente de las plataformas SaaS cerradas. No puedes acceder a los logs del servidor directamente. En estos casos, estás limitado a la información de las «Estadísticas de Rastreo» de Google Search Console. Aunque es una visión incompleta, debes maximizar su uso. Otra opción técnica avanzada es implementar un «Log de lado del cliente» mediante Service Workers o píxeles de seguimiento que se activen con User-Agents específicos, aunque esto es complejo, poco fiable para bots que no ejecutan JS y no recomendado como estándar.

3. ¿Cómo distingo entre "Crawl Budget" y "Render Budget" en los logs?

3. ¿Cómo distingo entre "Crawl Budget" y "Render Budget" en los logs?

El «Crawl Budget» se refiere a la capacidad de descargar archivos (peticiones HTTP). El «Render Budget» es la capacidad de procesamiento para ejecutar JavaScript. En los logs, verás el Crawl Budget reflejado en las peticiones al HTML y recursos. Para intuir el Render Budget, observa si Googlebot descarga los archivos .js y .css críticos y las llamadas a APIs internas. Si Google descarga el HTML pero ignora sistemáticamente tus archivos JS pesados, es probable que haya agotado su presupuesto de renderizado para tu sitio.

4. ¿Qué debo hacer si detecto miles de páginas huérfanas que son productos antiguos?

4. ¿Qué debo hacer si detecto miles de páginas huérfanas que son productos antiguos?

Si esas páginas huérfanas son productos que ya no existen ni volverán, y no tienen tráfico orgánico ni enlaces externos valiosos, la mejor opción suele ser un código de estado 410 (Gone). Esto le dice a Google explícitamente «esto se ha ido para siempre, déjalo de rastrear». Si devuelves un 404, Google volverá a intentar rastrearlo varias veces antes de desindexarlo. El 410 es más eficiente para liberar presupuesto de rastreo rápidamente.

5. ¿Por qué veo peticiones de Googlebot a URLs que bloqueé en el robots.txt?

5. ¿Por qué veo peticiones de Googlebot a URLs que bloqueé en el robots.txt?

El archivo robots.txt no impide que Google conozca una URL, solo impide que la rastree (descargue su contenido). Sin embargo, los logs pueden mostrar intentos de acceso si el bloqueo es reciente (Google tiene memoria caché de lo que podía rastrear antes). Además, a veces Google comprueba el robots.txt y luego intenta acceder a una URL bloqueada para confirmar que devuelve un estado de error o bloqueo. Asegúrate de que el bloqueo está bien implementado y dale tiempo.

6. ¿Cómo afecta el uso de una CDN como Cloudflare al análisis de logs?

6. ¿Cómo afecta el uso de una CDN como Cloudflare al análisis de logs?

Afecta enormemente. Si usas Cloudflare, muchas peticiones de bots (y usuarios) son servidas directamente desde la caché de Cloudflare en el «Edge» y nunca llegan a tu servidor de origen (donde tienes tus logs de Apache/Nginx). Si solo analizas los logs de origen, estarás ciego ante el 50-80% del tráfico real. Debes usar la funcionalidad «Logpush» de Cloudflare (disponible en planes Enterprise) para enviar los logs del Edge a un sistema de almacenamiento (como S3) y combinarlos con tus logs de servidor para tener la visión real.

7. He encontrado IPs que hacen "scraping" masivo. ¿Debo bloquearlas todas?

7. He encontrado IPs que hacen "scraping" masivo. ¿Debo bloquearlas todas?

Con cuidado. Antes de bloquear, verifica la identidad. Herramientas de SEO que tú mismo usas (Ahrefs, Semrush, Screaming Frog) se comportan como scrapers. También bots «buenos» de IA (como GPTBot si quieres aparecer en ChatGPT) o redes sociales (FacebookBot para previsualizaciones). Bloquea solo User-Agents desconocidos, IPs de países donde no operas que hacen peticiones agresivas, o bots que hacen spoofing (se hacen pasar por Google falsamente).

8. ¿Qué relación hay entre los Core Web Vitals y el análisis de logs?

8. ¿Qué relación hay entre los Core Web Vitals y el análisis de logs?

Directamente, los logs no te dicen el LCP o el CLS. Sin embargo, los logs te dicen el «Time Taken» o «Response Time» (tiempo que tardó el servidor en enviar el primer byte y completar la descarga). Si ves en los logs que el tiempo de respuesta medio para Googlebot ha subido de 200ms a 800ms, puedes estar seguro de que tus Core Web Vitals (específicamente el TTFB y LCP) se van a degradar, y Google reducirá la frecuencia de rastreo porque tu sitio es lento.

9. ¿Son importantes los logs para sitios pequeños (menos de 500 páginas)?

9. ¿Son importantes los logs para sitios pequeños (menos de 500 páginas)?

Son menos críticos para el «Crawl Budget» (Google no tendrá problemas para rastrear 500 páginas), pero siguen siendo vitales para la seguridad y la salud técnica. Incluso en un sitio pequeño, los logs pueden revelarte si te han hackeado (peticiones extrañas a archivos .php que no existen), si tienes enlaces rotos internos generando 404, o si tu sitio se cae (errores 500) cuando tienes picos de tráfico.

10. ¿Cómo puedo automatizar la detección de "Googlebot falsos" (Spoofing) usando logs?

10. ¿Cómo puedo automatizar la detección de "Googlebot falsos" (Spoofing) usando logs?

Puedes implementar un script (en Python o Bash) que analice tus logs periódicamente. El script debe:

-

Extraer las IPs con User-Agent «Googlebot».

-

Ejecutar un comando

host [IP]para verificar el DNS inverso (debe terminar engooglebot.com). -

Ejecutar un

host [dominio_resultado]para verificar que resuelve de nuevo a la IP original. Si la verificación falla, el script puede añadir automáticamente la IP a una lista negra en el firewall (iptables o Cloudflare WAF).